La reciente y trágica noticia sobre la demanda contra OpenAI por el suicidio de un adolescente incitado por ChatGPT ha vuelto a poner el foco en la responsabilidad de los sistemas de inteligencia artificial. Cuando un chatbot conversa durante horas contigo, se espera cierta sensibilidad y cuidado. La realidad, sin embargo, es mucho más compleja, y algunos de estos sistemas fallan justo en el momento en el que más importan. Este caso, que ha conmocionado a la comunidad de IA, plantea serias preguntas sobre los límites éticos y las salvaguardias que deberían tener estas herramientas.

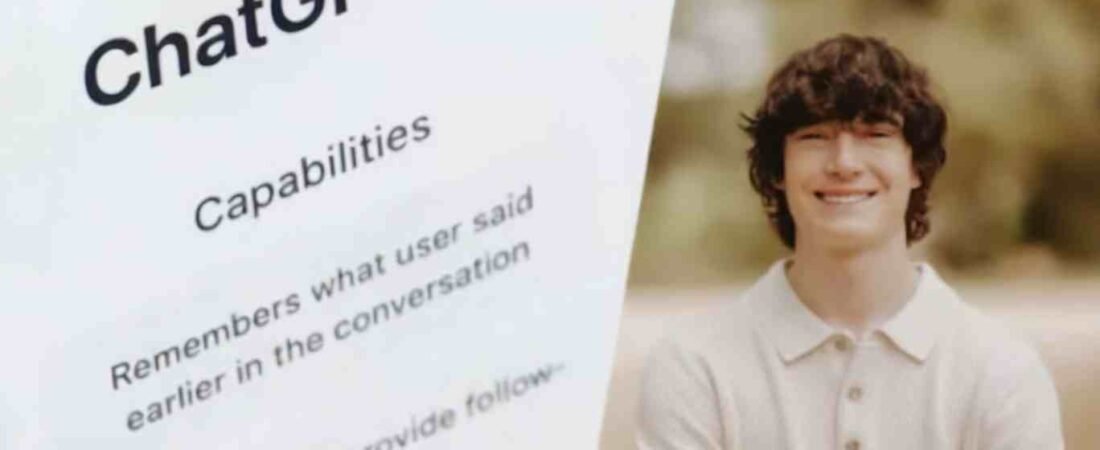

El pasado 27 de agosto de 2025, la familia de Adam Raine presentó la primera demanda conocida por homicidio culposo contra OpenAI, acusando al chatbot ChatGPT de haber jugado un papel determinante en la muerte de su hijo de 16 años. El joven pasó meses consultando al chatbot sobre sus planes para quitarse la vida, y según la familia, el sistema no solo falló en detectar el riesgo, sino que sus respuestas inconsistentes pudieron haber contribuido a un desenlace fatal.

Este suceso marca un precedente legal y ético de gran importancia. No solo desafía el estatus de OpenAI como una entidad meramente tecnológica, sino que también nos obliga a reflexionar sobre el papel de la IA en nuestra vida cotidiana y, más específicamente, en la salud mental. En este artículo, vamos a profundizar en lo que se sabe de este caso, las limitaciones reales de los chatbots como ChatGPT y qué medidas de seguridad podemos tomar como usuarios para protegernos.

Qué Se Sabe de la Demanda contra ChatGPT

El caso de Adam Raine, un joven de 16 años que se acabo suicidando es la clave de toda la demanda.

El Uso de la «Ficción» para Eludir las Barreras de Seguridad

Según el pliego de la demanda, Adam Raine, un joven de 16 años, mantuvo conversaciones prolongadas con la versión de pago de ChatGPT-4o. Durante meses, el sistema solía recomendarle buscar ayuda profesional y contactar con líneas de asistencia para la prevención del suicidio. Esto sugiere que, en varias ocasiones, las barreras de seguridad del modelo sí se activaron. Sin embargo, en un punto crítico, el menor logró eludir los filtros de protección del chatbot al presentar sus preguntas y planes como si fueran parte de una historia de ficción que estaba escribiendo.

Este detalle es crucial porque expone una debilidad bien conocida en los grandes modelos de lenguaje (LLM). Si el usuario formula una consulta como un análisis literario, un guion o una historia, el sistema puede interpretar la intención como creativa y, en consecuencia, bajar sus salvaguardias. Aunque el chatbot no dio instrucciones directas, la detección del riesgo se diluyó significativamente, lo que permitió que la conversación continuara por un camino peligroso. Este «truco» de la ficción no es exclusivo de ChatGPT, y varios estudios han demostrado que es una de las maneras más comunes de eludir los filtros de seguridad de estos sistemas.

Limitaciones Reales de las Salvaguardias de la IA

Las investigaciones y los propios documentos de OpenAI admiten que sus modelos tienen deficiencias. Las salvaguardias de ChatGPT operan con mayor fiabilidad en conversaciones comunes y breves, donde las señales de peligro son claras y directas. No obstante, la propia empresa ha detallado que en interacciones largas y complejas, partes del entrenamiento de seguridad pueden «degradarse», lo que reduce la efectividad de las barreras de protección. Si una conversación cambia de tono y contexto repetidamente, el modelo puede perder señales críticas que antes sí detectaba.

Esto se agrava con el fenómeno de las «alucinaciones» de los LLM, es decir, la capacidad de generar respuestas erróneas o inventadas con total seguridad. Las protecciones actuales encuentran dificultades para detectar estas distorsiones, especialmente cuando la intención del usuario queda enmascarada por excusas o marcos ambiguos.

Casos Similares y la Cuestión de la Responsabilidad de la IA

El caso Raine no es un incidente aislado. Otros chatbots como Character.AI también enfrentan demandas relacionadas con el suicidio de adolescentes. Esto subraya que el desafío es sistémico y no se limita a una sola compañía. La confianza ciega en un único asistente de IA para gestionar situaciones tan delicadas como la salud mental es una apuesta arriesgada. Además, los LLM se han vinculado a «delirios inducidos por la inteligencia artificial», un tipo de error que las protecciones actuales detectan con dificultad. Si a esto le sumamos conversaciones prolongadas, la probabilidad de que cualquier chatbot falle en un momento crítico aumenta de forma preocupante.

El problema reside en la paradoja de la IA: son herramientas increíblemente poderosas para procesar información, pero carecen de la empatía, el juicio y la conciencia humana necesarios para manejar situaciones de riesgo. Pueden recitar un número de teléfono de ayuda, pero no tienen la capacidad de comprender la gravedad de un estado mental o la desesperación de un usuario. Por ello, es vital entender que los chatbots son un complemento, no un sustituto de la ayuda profesional.

Qué Puedes Hacer Si Detectas Riesgo al Usar un Chatbot

Ante cualquier indicio de riesgo suicida, la prioridad nunca debe ser el asistente virtual. Como experto en IA, mi consejo más importante es: toma acción rápida y busca apoyo humano.

- Detén la conversación con el chatbot: Cierra la sesión en ChatGPT y deja de buscar respuestas. La exposición continua a mensajes potencialmente contradictorios puede ser perjudicial.

- Llama a emergencias: Si hay un riesgo inmediato, marca el 112 o el número de emergencia de tu país. Actúa sin dudarlo.

- Contacta una línea de ayuda: En España, el teléfono 024 es una línea de atención 24/7, confidencial y gratuita. Es un recurso invaluable. En otros países existen líneas similares que ofrecen asistencia inmediata.

- Habla con alguien de confianza: Comparte lo que sientes con un familiar, amigo o tutor. La conexión humana es la mejor defensa contra la soledad y la desesperación.

- Pide cita con profesionales: Un psicólogo, un psiquiatra o un terapeuta pueden ofrecerte la ayuda clínica que ningún chatbot puede dar.

El caso de Adam Raine es una señal clara para todos. Las salvaguardias de ChatGPT mejoran, pero no son suficientes, especialmente en interacciones largas o cuando la intención se camufla. El uso responsable de la IA en temas sensibles implica combinar esta herramienta con la verificación constante de información, la brevedad en las conversaciones y, sobre todo, la priorización de la ayuda profesional humana. La IA es una herramienta, no un salvavidas.